Actuel / Facebook: un danger public, vraiment?

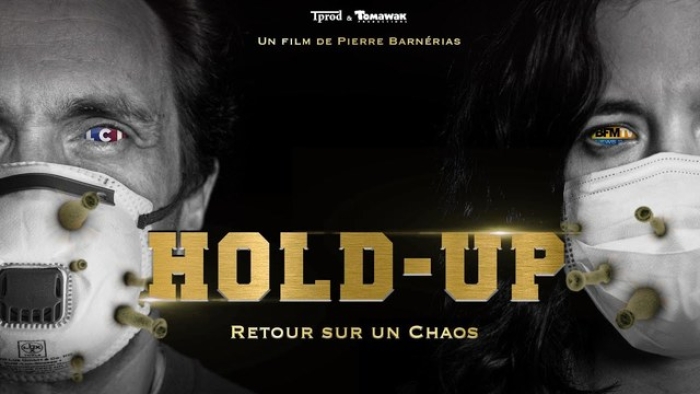

Depuis le début de la pandémie, Facebook est pointé du doigt pour son contrôle plus ou moins léger des nombreuses informations qui gravitent sur son réseau. Mark Zuckerberg, initialement frileux à jouer les polices du Web, a fini par durcir le ton dans la lutte contre la désinformation, par le biais de pratiques qui flirtent parfois avec la censure. Mais les efforts déployés ne suffisent pas. L’influence du réseau est hors de contrôle, trop étendue pour son créateur. Toute la question est de savoir si c’est plutôt une bonne ou une mauvaise chose…

«Je crois fermement que Facebook ne devrait pas jouer les arbitres de la vérité de ce que les gens disent sur le Net», déclarait Mark Zuckerberg en mai dernier, prenant ainsi le contrepied du créateur de Twitter qui n’a pas hésité à mettre les bouchées doubles dans la traque aux fake news, dans le but notamment de décrédibiliser Donald Trump. Pourtant, cela fait plusieurs années que Facebook, régulièrement critiqué pour son laxisme, a pris ses responsabilités en partant à la chasse aux fausses informations. Pendant la pandémie, le plan d’action a été renforcé: «Grâce à notre réseau international de fact-checkers, nous avons ajouté des avertissements à 98 millions d’articles de désinformation concernant le Covid et supprimé 7 millions d’entre eux qui représentaient un danger imminent, explique un porte-parole de Facebook. Nous avons dirigé 2 millions de personnes vers les autorités sanitaires compétentes et lorsque quelqu’un essaie de partager un lien concernant le Covid, un pop-up destiné à les connecter aux informations plus crédibles apparait, contenant notamment le contexte de la source et de la date du lien en question.»

Le règlement concernant les publicités a également été renforcé, jusqu’à basculer dans l’incohérence. Il n’est désormais pas possible de «booster» librement une publication qui «exploiterait des crises ou des enjeux sociaux ou politiques controversés à des fins commerciales». Mais des erreurs peuvent être commises et des articles comme celui concernant le business de la peur, publié par L’Impertinent, ont été injustement blacklistés. Facebook propose alors une publication restreinte, limitée géographiquement, de la publicité, afin de réduire son impact. Une entrave qui, selon sa définition, pourrait concerner l’ensemble de la presse!

«Danger public»

Mais tout cela ne suffit pas. Pour l’ONG Avaaz, spécialisée dans le cybermilitantisme, «l’algorithme de Facebook est un danger majeur pour la santé publique». «Mark Zuckerberg a promis des informations fiables pendant la pandémie, mais son algorithme sabote ces efforts en dirigeant les 2,7 milliards d’utilisateurs de Facebook vers des réseaux propagateurs de désinformation», a déclaré son directeur de campagne, Fadi Quran. Ce dernier reproche notamment à Facebook d’héberger 42 pages, suivies par 28 millions de personnes pour 800 millions de vues sur des fake news.

«Nous partageons l’objectif d’Avaaz de limiter la désinformation, mais leurs conclusions ne sont pas révélatrices des actions entreprises afin de l’empêcher de se répandre sur nos services, explique Johannes Prüller, porte-parole de Facebook pour la Suisse et l’Autriche. «Depuis 2018, nous supprimons la désinformation qui pourrait contribuer à un danger physique imminent. Nous appliquons la même politique depuis le début de la pandémie Covid-19 et supprimons les posts qui propagent de fausses informations sur les remèdes, les traitements et la disponibilité des services essentiels ou encore la localisation et la gravité des clusters. Les suppressions de posts, basées sur les directives de l’OMS et autres autorités sanitaires, sont régulièrement mises à jour.»

Facebook s’est associé à des fact-checkers censés déterminer où est la vérité, comme s’il en existait qu’une seule. En Suisse, c’est Keystone/ATS qui se charge d’établir ce qui est vrai ou faux. En France, la mission a été confiée à plusieurs médias, dont Le Monde. Un quotidien qui a reçu plus de 4 millions de dollars de dons de la Bill & Melinda Gates Foundation, ces huit dernières années. Un état de fait dont personne ne semble s’émouvoir, comme le rappelait récemment l’Antipresse de Slobodan Despot. Comment s’assurer alors que les estimations ne soient pas biaisées? Comment garantir un débat démocratiquement sain sans avoir accès à des opinions contradictoires et à différentes manières d’exposer les faits que l’on tient pour acquis?

Fiorenza Gamba, de l’Institut de recherches sociologiques à l’Université de Genève, estime que la vérité est un terme compliqué à définir: «Il y a une multiplicité dans la production des informations et dans leur sélection qui démultiplie les points de vue, explique-t-elle. Selon une tradition philosophique, l’herméneutique de Gadamer, ‘la vérité est un pluriel qui va se composer, elle est toujours partielle’. On a tendance à penser qu’il y a le vrai d’un côté et le faux de l’autre, mais le Covid nous montre la difficulté d’identifier les deux. Par exemple, nous avons vu des positions, des suggestions et des mesures qui ne sont pas l’expression d’une vérité unique, mais des propositions très ambiguës, parfois opposées l’une à l’autre. Il est difficile de trouver une vérité unique.»

Pour la chercheuse, les réseaux sociaux, en tant que structure, s’accordent mal à la tentative de contrôler et de définir ce qui peut être montré et posté de ce qui doit être effacé: «Lorsque Facebook dit essayer d’éliminer les informations, ça ne peut être fait qu’en partie, puisque les gens ont une grande possibilité de poster les contenus les plus divers. Est-ce que le contrôle est un contrôle de bonne foi ou un contrôle dirigé par des intérêts plus ou moins déclarés et donc plus ou moins acceptables? C’est difficile à dire, en particulier pour un réseau qui a un passif chargé sur le plan de l’exploitation des données personnelles. Dans ce contexte, il est compliqué d’accorder sa confiance à cette structure.»

«Nous ne voulons certainement pas jouer aux arbitres de la vérité et nous savons que ce n’est pas non plus ce que les utilisateurs de Facebook attendent de nous, ajoute Johannes Prüller, qui répète mot pour mot le discours officiel de l’entreprise. Nous travaillons dur afin de trouver l’équilibre entre favoriser la liberté d’expression d’un côté et assurer une communauté authentique et sûre de l’autre. Nous croyons que le juste milieu se situe dans le déclassement du contenu fallacieux. En d’autres termes, nous permettons aux gens de poster ce qu’ils veulent, mais nous nous arrangeons pour ne pas que les fausses informations soient mises en valeur sur le fil d’actualité.»

Eternel mauvais élève de la course à la pensée unique, Facebook semble être devenu trop grand pour son créateur. Ou alors peut-être que ce dernier n’est pas aussi convaincu par ses propres décisions qu’il ne veut bien le faire croire…

VOS RÉACTIONS SUR LE SUJET

0 Commentaire